什么是robots.txt文件

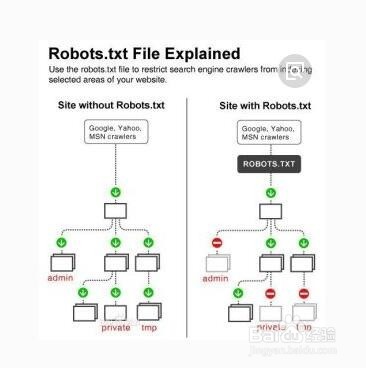

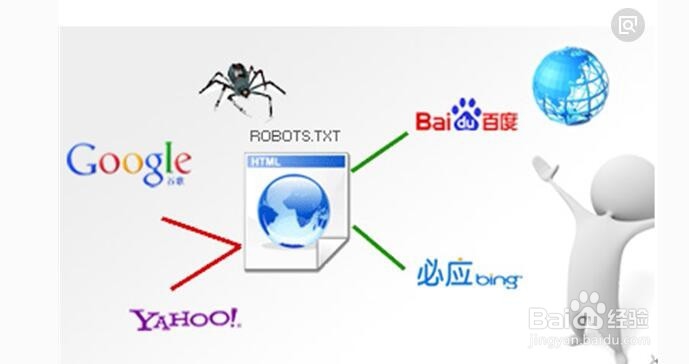

1、有什么作用Robots协议是网站国际互联网界通行的道德规范,其 目的是保护网站数据和敏感信息、确保用户个人信息和 隐私不被侵犯。因其不是命令,故需要搜索引擎自觉遵守。

2、一个网站为什么要写robots.txt1、保护网站安全2、节省流量3、禁止搜索引擎收录部分页面4、引导蜘蛛爬网站地图

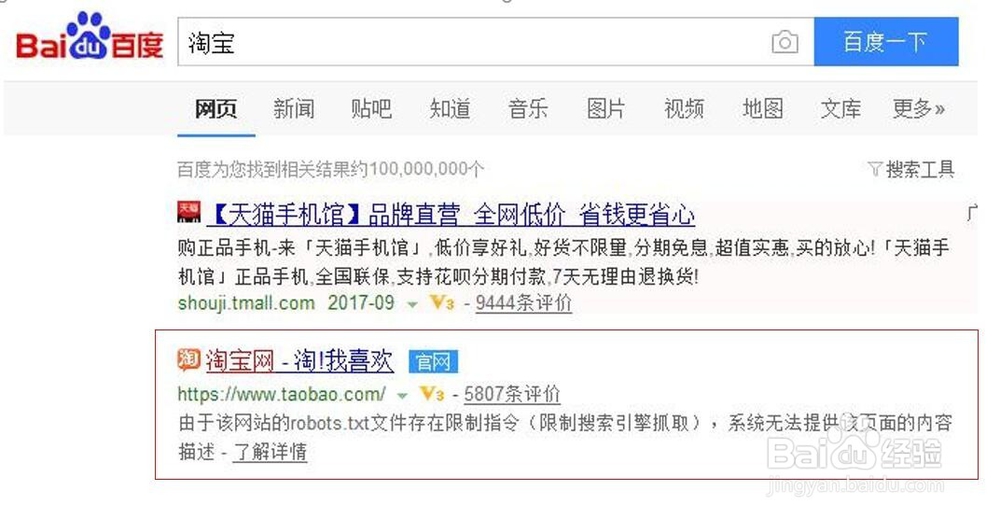

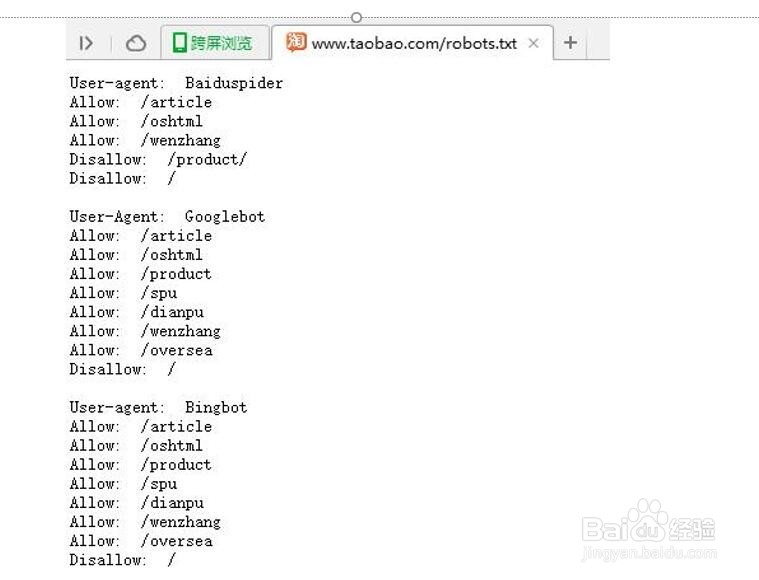

3、淘宝的robots.txt

4、淘宝的robots.txt

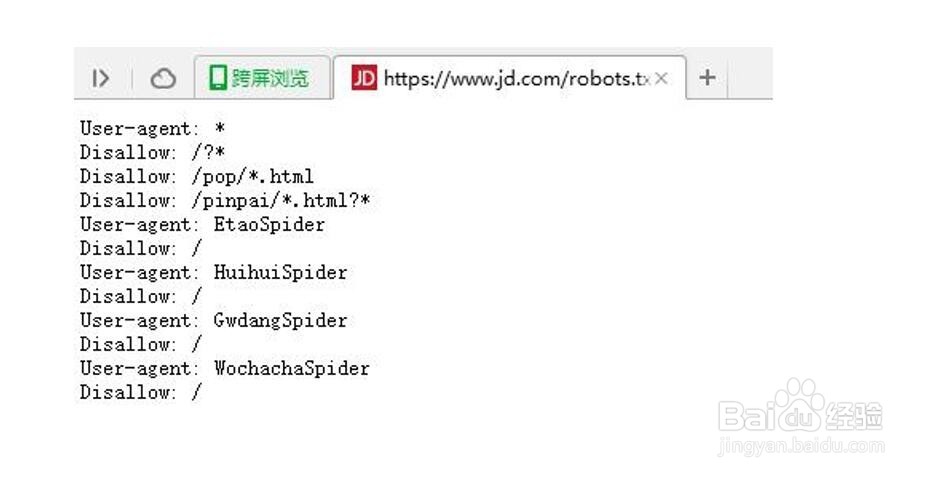

5、京东的robots.txt

6、Robots.txt放置位置Robots.txt文件应该放置在网站根目袄嬖艽蛞录下 例如:当spider访问一个网站(http://www.xxx.艘早祓胂com)时,首先会检查该网站中是否存在http://www.xxx.com/robots.txt这个文件,如果 Spider找到这个文件,它就会根据这个文件的内容,来确定它访问权限的范围。

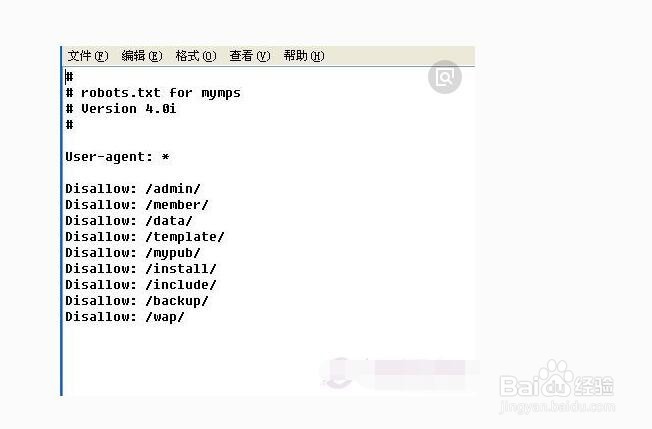

7、Robots.txt文件的写法User-agent: * 这里的*代表的所有的搜索引擎种类,*是一个通配符肛舀辨乔Disallow: /admin/ 这里定义是禁止爬寻admin目录下面的目录Disallow: /*?* 禁止访问网站中所有包含问号 (?) 的网址Disallow: /.jpg$ 禁止抓取网页所有的.jpg格式的图片Disallow:/ab/adc.html 禁止爬取ab文件夹下面的adc.html文件。Allow: /cgi-bin/ 这里定义是允许爬寻cgi-bin目录下面的目录Allow: .htm$ 仅允许访问以".htm"为后缀的URL。Allow: .gif$ 允许抓取网页和gif格式图片Sitemap: 网站地图 告诉爬虫这个页面是网站地图

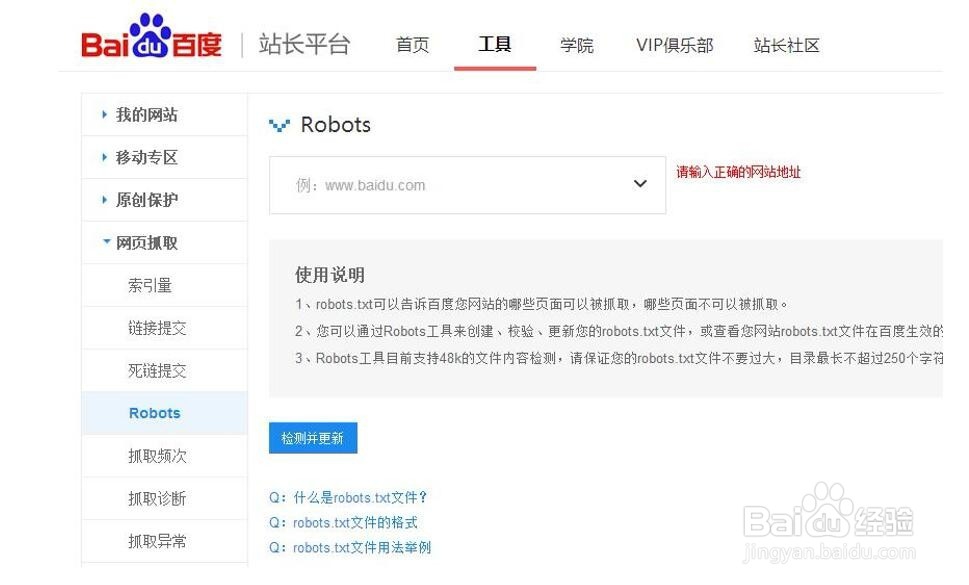

8、百度站长平台创建robots